Andrew Ng 3일차-Friedberg 교재 활용

2주차 강의부터는 본격적으로 선형대수학의 내용이 나온다. 계수 벡터들을 활용하여 벡터곱을 통해 그래프를 만들어내는 것인데, 내가 지난 학기에 피땀눈물 흘려가며 B0를 받아내야만 했던 이창우 교수님의 선형대수학을 떠올리게 만들었다. 그래 학점이 뭐가 중요하랴 공부한 것이 얼마나 남느냐가 중요한거지...

그래서 지난학기 선대 강의시간에 활용했던 Friedberg's Linear Algebra 를 활용하여 공부를 병행하기로 했다. 강의에서도 설명을 해주긴 한다만 교재와 함께라면 수업시간을 통해 습득하였던 선대의 큰그림을 계속해서 상기할 수 있을 듯 하다.

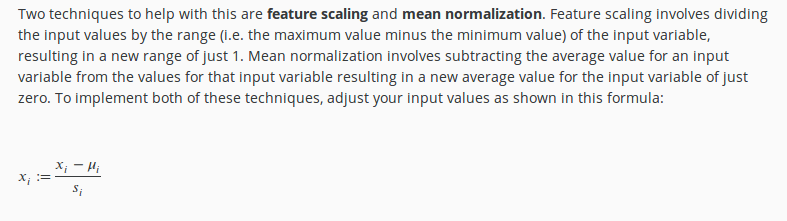

여기서 나오는 mean normalization을 보고 선대 교재를 봐야겠다 빡 느낌이 왔다. 지난 학기 수업 시간에는 간단하게 언급하고 넘어갔던 내용으로 기억하지만 내가 분명히 이 방법을 쓰면 굉장히 편리하겠다! 생각을 했었다.

friedberg 교재에서 mean normalization 은 최소자승법을 설명하는 부분에서 등장하였다. 최소자승법이란 우리가 배우고 있듯이 실제데이터를 직선화하여 예측하는 모델을 뜻하는데 least sqares approximation 이라는 영어 이름이 좀 더 직관적으로 다가올 것이다.

J를 최소로 하는 세타 값들을 찾는 것이므로 최소자승법이라는 이름이 붙었다.

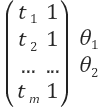

실제 데이터 y 값들에 대응하는 Θt+Θ들은 행렬의 곱으로 표현이 가능하다. 데이터의 개수 m 에 대해

의 형태로 (m x 1)크기의 행렬이 탄생하게 되는 것이다.

여기까지는 기본적인 내용이지만 이제부터 왜 mean normalization 이 중요한지를 확인하려면 선형대수학의 기본부터 차근차근 다시 이해해야 할 것 같다. 알고보니 최소자승법이 굉장히 복잡한 문제였다. 하긴 여러개의 데이터 사이를 잇는 최적의 선을 하나의 수식으로 만들어 내는데 간단할 것이라고 생각하는게 잘못이었다...

댓글

댓글 쓰기